«Мои руки в крови» Тысячи людей страдают и умирают из-за постов в соцсетях. Почему никто не хочет им помочь?

16:00, 25 октября 2021Каждый день тысячи людей проверяют миллионы ужасающих постов в соцсетях. Они смотрят на детское порно и массовые расстрелы, убийства и расчлененку, издевательства над животными и самоубийства. Это модераторы, и они подчищают то, что не смогли распознать алгоритмы, на базе которых работают крупнейшие соцсети мира. И эти люди буквально погибают на рабочих местах, страдая от психических расстройств без всякой надежды на помощь. Почему это происходит и как отражается на том, что видят в соцсетях миллиарды пользователей, «Лента.ру» рассказывает в рамках спецпроекта «Алгоритм. Кто тобой управляет?»

«Я был так напуган»

23-летний Шон Спигл угробил здоровье и психику всего за полгода работы на Facebook. На собеседовании ему пообещали, что он будет изучать поведение пользователей соцсети и, возможно, модерировать контент. Шон согласился, потому что его заинтересовала первая часть предложения. Но он ни разу не столкнулся с анализом поведения пользователей — вместо этого Шон несколько месяцев просматривал тысячи жутких постов.

В интервью Шон Спигл со слезами на глазах рассказал, как впервые столкнулся с работой модератора. До этого он был волонтером в приюте для животных. На первом же видео ему пришлось смотреть, как живодеры жестоко убивали игуану. Потом он наблюдал, как люди бросают щенков в кипяток и засовывают им в пасть зажженные фейерверки. И это была лишь малая часть того, что ему приходилось оценивать каждый день.

Скоро Спигл понял, что не может спать больше двух-трех часов в сутки. Он просыпался в холодном поту и долго рыдал. Он бросил спорт, на который не хватало ни физических, ни моральных сил, и ссорился с родителями по пустякам.

В офисе на протяжении всего рабочего дня за ним, как и за всеми модераторами, постоянно следили. Ему запрещали отходить от компьютера, лишний раз сходить в туалет, говорить с коллегами и родными.

«Я чувствовал себя в ловушке. Я не мог, хоть убей, встать из-за стола, иначе на меня кричали бы, чтобы я оставался на рабочем месте... Я был так напуган», — вспоминал Спигл. Позже психиатр поставил ему диагноз посттравматическое стрессовое расстройство (ПТСР).

В похожей ситуации оказался Маркус — ветеран войны, который думал, что давно привык к насилию. Уже на второй день работы модератором он понял, как сильно ошибался. Ему пришлось внимательно смотреть ролик, в котором кто-то до смерти забивал щенков бейсбольной битой. В обеденный перерыв Маркус ушел домой, чтобы выплакаться. Он собирался уволиться в тот же день, но в итоге продержался на этой работе еще чуть больше года.

Морально-нравственные страдания

На Facebook модерация контента работает с 2004 года, фактически с момента основания соцсети. Когда-то всего несколько модераторов помогали пользователям вспомнить пароль от аккаунта и лишь изредка разбирались с жалобами.

Сегодня модератор каждый день отсматривает несколько сотен спорных постов. Спорным считается пост, на который пожаловался пользователь или который был помечен алгоритмом модерации как потенциально нарушающий правила соцсети.

Оценивать такие публикации — сложнейшая работа, требующая усидчивости и чрезвычайно крепкой психики. Модераторы ежедневно проверяют посты, содержащие сексуальное насилие, убийства, расчленение тел и прочие ужасы. Согласно отчету Центра бизнеса и прав человека при Нью-Йоркском университете, больше трети отсматриваемого модераторами контента (39,5 процента) связано с обнаженкой и сексом. Еще четверть приходится на жестокость и расчлененку. Около 30 процентов — это терроризм, оскорбления, посты об оружии и наркотиках. Еще 9 процентов — детская порнография.

«В этой работе нет ничего приятного. Вы приходите в 9 утра каждый день, включаете компьютер и смотрите, как кому-то отрубают голову. Это то, что вы видите каждый день, каждую минуту: отрубают головы», — рассказывал бывший модератор Facebook.

Эти люди в ручном режиме отслеживают и оценивают то, что не смогли распознать алгоритмы. Но, в отличие от алгоритмов, у живых людей есть психика. И она не выдерживает таких испытаний — большинство модераторов увольняются с диагнозом посттравматическое стрессовое расстройство. Это тяжелое психическое состояние, которое обычно преследует ветеранов войн.

Модераторы не могут поделиться своими переживаниями с друзьями или родными — это запрещено договором о неразглашении. Из-за этого они страдают еще больше. Многие после изучения сотен постов конспирологов натурально сходят с ума: искренне начинают верить, что Земля плоская, холокост выдуман, а теракты устраивает теневое правительство.

Ни минуты покоя

Почему Facebook не наймет больше людей и не обеспечит им безопасность? Потому что формально модераторы не работают в Facebook — компания нанимает для этого подрядчиков. А те берут фрилансеров, которые трудятся за 15 долларов (около 1 тысячи рублей) в час: в некоторых штатах эта ставка едва превышает минимальный размер оплаты труда.

В таких компаниях царит армейская дисциплина. В одной из них — Cognizant — временем сотрудников управляют до минуты. Чтобы сделать перерыв, человек должен уведомить об этом руководство. В день у модератора есть получасовой обед и два 15-минутных перерыва, в которые входит посещение туалета. Из-за напряженного графика в туалет обычно не попасть: во время перерыва туда идут буквально все. Об отдыхе и думать не приходится.

У модераторов есть «оздоровительное время», и на это отводится целых девять минут в день. Девять минут в день, чтобы немного оправиться от увиденных ужасов или ненадолго закрыть глаза в попытке отвлечься. Работники-мусульмане поначалу тратили это время на молитву, но руководство запретило и это.

Для сотрудников есть служба психологической поддержки — каждый модератор может поговорить с консультантом лично или по телефону, — но этим практически никто не пользуется. В большинстве случаев это не реальные психотерапевты, а неквалифицированные «эксперты по здоровью»: они советуют медитировать, ходить в бассейн или на йогу. Такие советы весьма ожидаемо не помогают справиться со стрессом. Один из «экспертов по здоровью», выслушав все ужасы модерации, и вовсе порекомендовал сотруднику употреблять наркотики.

И, судя по многочисленным анонимным откровениям модераторов, это один из самых популярных способов удержаться на работе и не сойти с ума. Чтобы снять стресс, большинство сотрудников сидят на наркотиках, пьют или занимаются беспорядочным сексом.

«Мой сын умер здесь»

ПТСР и депрессия — далеко не худший исход для модераторов соцсетей. Некоторые сотрудники чувствуют себя настолько плохо, что буквально умирают на рабочем месте. Так произошло с 42-летним бывшим американским военным Китом Атли, который в марте 2018 года умер от сердечного приступа прямо на смене. Приехавшие на вызов медики забрали уже посиневшего Атли в больницу, но спасти его не успели.

Атли работал в той самой компании Cognizant, и там всеми силами пытались скрыть его смерть от других сотрудников. Тайна раскрылась, когда в офис приехал отец погибшего и сказал коллегам Кита: «Мой сын умер здесь». Но даже после этого в Cognizant это отрицали.

По словам коллег, Атли крайне остро переживал давление со стороны начальства. Он пытался соответствовать всем стандартам качества, но боялся, что его уволят из-за ошибок. До увольнения он так и не дожил.

Черт ногу сломит

Отдельная причина стресса — максимально запутанные инструкции для модераторов. Бывшие и нынешние сотрудники жаловались, что их и без того изнурительная работа усложнялась внезапными изменениями правил. Они постоянно изучали гигантские документы с расплывчатыми формулировками и непонятными диаграммами. Толковать инструкции можно было как угодно.

Правила модерации могли меняться в каждом конкретном случае. К примеру, после смерти рэпера XXXTentacion в 2018 году Facebook заполонили издевательские посты о музыканте, которого еще при жизни обвиняли в избиении девушки.

Модераторы тогда впали в ступор. С одной стороны, насмешки над гибелью человека должны быть запрещены, с другой — речь шла о потенциальном абьюзере. Начальство тоже было в замешательстве: сначала они приказывали помечать весь подобный контент как «жестокий», но после передумали. Шутки о погибшем рэпере-насильнике официально разрешили.

Из-за таких случаев между руководством Facebook и подрядчиками постоянно возникают нестыковки. В Facebook выдают новые правила, начальство пытается объяснить их модераторам, а они интерпретируют их по-своему. Задавать вопросы сотрудникам Facebook почти бесполезно: они не могут объяснить то, что сами же написали. В результате модераторы вынуждены лишь догадываться, как оценивать публикации. За ошибки их штрафуют и увольняют.

Зачем нужны живые модераторы?

Facebook пользуются более двух миллиардов людей. Кажется, обеспечить безопасность такого количества пользователей просто невозможно. Но речь идет о компании с оборотом 533 миллиарда долларов в год и штатом 40 тысяч сотрудников. И эта компания выделила на модерацию контента всего 15 тысяч человек. Для такой платформы цифра просто ничтожная — это всего 0,0005 процента от общего числа пользователей, многие из которых публикуют по несколько постов в день, а иногда и в минуту.

Facebook постоянно модернизирует алгоритмы для модерации и рассказывает о будущем, в котором всю грязную работу будут делать не люди, а роботы. Но пока человек в этой цепочке незаменим, ведь автоматическая модерация чаще вредит, чем приносит пользу.

Ежедневно алгоритмы блокируют совсем не то, что даже размытые правила Facebook признают неприемлемым. Так, в мае 2020 года многочисленные пользователи пожаловались на то, что Facebook заблокировал фотографии 1945 года, на которых советские военные Михаил Егоров и Мелитон Кантария устанавливают Знамя Победы на Рейхстаге. Фотографии были удалены с формулировкой «нарушение норм сообщества в отношении опасных людей и организаций». Никто не знает, что это значит, а в Facebook на претензии не отвечают.

В октябре 2019 года главный редактор Russia Beyond Всеволод Пуля пожаловался на удаление страницы проекта Russian Kitchen, где публиковались рецепты русской кухни. На группу были подписаны 40 тысяч человек. После того как из-за удаления разразился скандал, Facebook молча вернул доступ к странице, но на всякий случай ограничил показы. Платформа, как и во всех случаях за пределами США, подобное никогда не комментирует.

В 2018 году широкий резонанс получила фотография улыбающегося президента Франции Эммануэля Макрона, позировавшего с темнокожими полуобнаженными жителями острова Сен-Мартен. Первым пострадал Макрон, которого раскритиковали за неподобающий его статусу внешний вид, а за ним и пользователи, опубликовавшие снимки на своих страницах в Facebook. Алгоритмы соцсети разглядели на фото «наготу» и «сексуальный контент». Любопытно, что изображения были удалены только через пару месяцев после публикации.

За «чрезмерную сексуальность» банили даже фотографии репчатого лука. Фермер собирался продавать семена растения на Facebook, но его объявления удалили буквально через несколько минут после публикации. Новость о «слишком сексуальных луковицах» быстро разлетелась по СМИ, поэтому администраторам Facebook пришлось отреагировать. Впрочем, ничего нового они не сказали: сотрудники платформы восстановили объявление и обвинили в случившемся алгоритм.

Борьба с фейками

Помимо нарушений правил платформы, Facebook и Instagram следит и за распространением фейковых новостей. Такое разделение появилось в 2016 году, когда за пост президента США яростно боролись Дональд Трамп и Хиллари Клинтон. Победа республиканца Трампа стала для демократов большим ударом, и обвиняли в этом в том числе Facebook.

В ходе предвыборной гонки сторонники Трампа буквально заполонили самую популярную в мире социальную сеть фейковыми новостями о Хиллари Клинтон. Сообщения были самые разнообразные: в каких-то говорилось о прогрессирующем маразме кандидатки от демократов, а в других дата выборов была намеренно написана с ошибкой. Все публикации объединяли кричащие заголовки и привлекающие взгляд картинки.

Пользователи реагировали на посты бурно: одни поддерживали их лайками, другие ругались в комментариях. Для алгоритмов Facebook все это означало лишь одно: пользователи показывали высокую вовлеченность, а это главный критерий для того, чтобы автоматическая система показывала эти посты огромному числу людей. Алгоритмы не умели отличать дезинформацию от обычных новостей, поэтому активно помогали в распространении фейков.

В итоге в победе Трампа обвинили Марка Цукерберга. Ему пришлось быстро решать эту проблему. Проверку фейковых новостей передали якобы непредвзятым организациям. Сейчас свои фактчекеры есть в 50 странах мира.

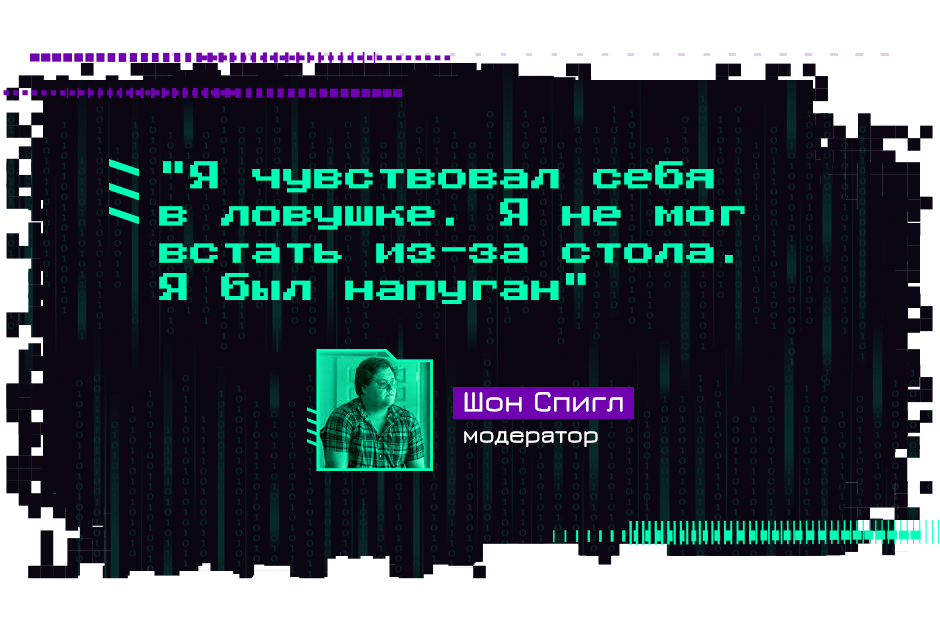

Каким образом Facebook проверял профессионализм и непредвзятость фактчекеров — неизвестно. Но уровень их экспертности в разных странах мира сильно разнится. К примеру, в США за проверку отвечает одно из крупнейших в мире международных агентств новостей Reuters, а российские и украинские посты оцениваются украинской организацией StopFake, которая никогда не отличалась беспристрастностью.

StopFake работает более семи лет. Facebook начала сотрудничать с ней весной 2020 года. Вскоре американские журналисты быстро выяснили, что в России с фейками будут бороться люди, которые связаны с радикальными объединениями.

В июле 2020 года украинское издание «Заборона» подробно рассказало о связях StopFake с лидерами ультраправых и неонацистских группировок. В материале говорилось о главном лице StopFake – Марко Супруне, который анализирует российские фейки. К примеру, в 2017 году он выступил на «Молодежном националистическом конгрессе» – это известная националистическая организация на Украине. Вместе с ним на сцене были основатель популярного среди ультраправых бренда одежды «SvaStone» Арсений Билодуб и фронтмен рок-коллектива «Кому Вниз» Андрей Середа. Последний в одном из выступлений заявлял, что украинская земля – «мать арийской расы». Журналисты также выяснили, что Супрун давно дружит с представителем ультраправой партии «Правый сектор» (организация запрещена в РФ) Дмитрием Савченко.

Через некоторое время главреду «Забороны», одному из авторов материала Екатерине Сергацковой начали угрожать убийством, и ей пришлось бежать из страны.

В марте 2021 года с цензурой от StopFake столкнулись многие российские СМИ. Тогда страницы сразу нескольких крупнейших изданий получили предупреждение о публикации фейков. Ложной StopFake показалась новость о задержании украинской молодежной радикальной группы МКУ в Воронеже, написанная по пресс-релизу ФСБ. Под горячую руку StopFake попали публикации «Ленты.ру», РБК, «Ведомостей», ТАСС и «Коммерсанта». Роскомнадзор потребовал от Facebook разблокировать все статьи и объяснить, почему данные ФСБ оказались для платформы фейком.

«Мы не удаляли ни один из упомянутых типов контента с нашей платформы», — ответили представители Facebook. Как и в большинстве случаев, соцсеть лукавила: публикация была скрыта для пользователей, а красная метка на странице Facebook для СМИ означала ограничение в показах на неопределенный срок.

Facebook не прекратила совместную деятельность со StopFake даже после того, как о связях организации с ультраправыми и националистами рассказало одно из крупнейших американских изданий The New York Times.

Все сотрудничающие с Facebook сторонние организации подписывали обязательство быть непредвзятыми. Но при этом StopFake открыто заявляет, что получал финансирование от посольства Великобритании, министерства иностранных дел Чехии, национального фонда в поддержку демократии США и нескольких других организаций.

«Мы столкнулись с очень странной ситуацией»

Facebook — не единственная соцсеть, у которой есть очевидные проблемы с модерацией контента. Аудитория крупнейшего видеохостинга в мире YouTube — более двух миллиардов человек. Модераторы YouTube смотрят ролики, которые могут длиться как минуту, так и несколько часов. И если 15 тысяч модераторов Facebook катастрофически не справляются с объемами работы, то у YouTube их еще меньше — всего 10 тысяч человек.

В России только в 2021 году YouTube заблокировал интервью с вирусологом на телеканале RT и новостные выпуски о протестах против локдауна в Англии — из-за «дезинформации» о COVID-19; ролик на канале Алексея Навального; видео об окружении Рамзана Кадырова и многие другие материалы на каналах с тысячами подписчиков. Претензии авторов YouTube либо игнорирует, либо отвечает стандартной формулировкой «за нарушение условий использования». Телеканал «Царьград» уже почти год не может использовать YouTube, потому что его владелец, бизнесмен Константин Малофеев находится под санкциями США и ЕС.

Удаление каналов без предупреждения и объяснения причин — лишь один из методов борьбы YouTube с контентом, который платформа считает спорным. Куда более эффективно — лишать неудобных платформе блогеров монетизации, одного из главных средств заработка.

В 2017 году самый популярный в мире YouTube-блогер Феликс PewDiePie Чельберг в шутку попросил двух незнакомых индийцев потанцевать на камеру с табличкой «Смерть всем евреям», а потом ради смеха переоделся в фашистскую форму и поднял правую руку вверх под нацистский гимн. Это вызвало крупный скандал в СМИ. Из-за шумихи YouTube пришлось устроить блогеру публичную порку: его лишили монетизации и исключили из партнерской программы. В тот год Чельберг потерял минимум семь миллионов долларов.

Российские блогеры давно привыкли к тому, что YouTube не приносит денег и ограничивает монетизацию по любому поводу. Многие из них работают напрямую с рекламодателями и вставляют рекламные интеграции в ролики. Но для зарубежных авторов монетизация роликов — значительная часть зарплаты, которую они постоянно рискуют потерять.

Желтая или красная монета на ролике (ограничение или отключение монетизации) — главная проблема популярных блогеров. Загруженное видео еще до публикации оценивает алгоритм YouTube, и часто его решения необъяснимы. На то, чтобы оспорить ограничение, уходят дни и даже недели.

В 2017 году сразу несколько крупных российских авторов площадки заявили о резком падении доходов. Например, известный кинокритик Ануар ANOIR Тлегенов жаловался, что на его роликах резко сократилось количество рекламы, а он планировал оплачивать учебу с заработков на YouTube.

«До моего канала реклама в принципе не доходит, ее тупо на всех не хватает. Теперь мой доход, который раньше варьировался от 70 до 130 долларов, будет варьироваться между нулем и нулем долларов», — говорил Тлегенов, на канал которого на тот момент было подписано около 130 тысяч человек.

Тогда, как и сейчас, обращение в службу поддержки не помогло решить проблему.

Затаскали по судам

Несмотря на непрекращающиеся скандалы с модерацией, платформы отказываются осознавать масштабы бедствия. Доказать очевидное уже несколько лет пытается Софи Чжан, уволенная из Facebook специалистка по обработке и анализу данных. Софи утверждает, что руководство Facebook прекрасно осознает проблему, но не хочет ее решать.

Чжан проработала в Facebook три года, все это время она находила фермы ботов в разных странах и уговаривала руководство их ликвидировать. Так, специалистка обнаружила нескольких тысяч поддельных профилей, якобы поддерживающих президента Гондураса Хуана Орландо Эрнандеса. Действующее правительство Гондураса с помощью Facebook манипулировало мнением миллионов жителей страны и создавало иллюзию поддержки. Чжан понимала, что жизни этих людей буквально в ее руках.

Руководство отреагировало на ее жалобы лишь спустя девять месяцев. Две недели оно изучало ситуацию, а затем заморозило поддельные профили. После блокировки фейковых аккаунтов быстро появились новые. Но заниматься проблемами Гондураса дальше никто не стал.

В Азербайджане Чжан обнаружила, что правящая политическая партия использовала тысячи поддельных профилей для массового преследования оппозиции. Специалистка ждала реакции от руководства Facebook целый год. В итоге ничего не было сделано.

Другие случаи, обнаруженные Чжан, Facebook просто проигнорировал. Сотрудница видела, что в десятках стран соцсеть стала главным инструментом манипуляций людьми, и она была единственным человеком, которому было не все равно. В большинстве случаев она пыталась контролировать тысячи ботов собственноручно.

«Я знаю, что мои руки в крови», — говорит она о своей работе в Facebook.

Еще один сотрудник, осмелившийся пойти войной на соцсеть, — американка Селена Скола. Она работала модератором в Facebook около девяти месяцев, в результате у нее развилось посттравматическое стрессовое расстройство.

По словам Сколы, ни компания, ни подрядчик Pro Unlimited не смогли защитить ее от психологических травм. Даже после увольнения Селена не может держать в руке компьютерную мышь и боится громких звуков. Она одна из немногих, кто открыто потребовал возместить причиненный ей ущерб.

Выиграна битва, но не война

В 2020 году Facebook пообещал выплатить 52 миллиона долларов всем бывшим и нынешним модераторам, у которых развилось ПТСР из-за работы с шокирующим контентом.

Каждому модератору пообещали минимум 1000 долларов и дополнительную компенсацию в том случае, если у него диагностируют посттравматическое стрессовое расстройство или связанные с ним психологические травмы. На дополнительную компенсацию могут рассчитывать как минимум несколько тысяч человек.

С момента объявления о компенсациях прошел год. О выплатах пока ничего неизвестно.

В апреле 2021 года очередной анонимный модератор не выдержал ежедневного просмотра обезглавливаний и уволился. Перед этим он отправил журналистам записку, в которой рассказал о наплевательском отношении Facebook к модераторам. Вместо реальной помощи им по-прежнему советуют делать дыхательные упражнения для успокоения.

«Если сделать несколько глубоких вдохов или представить солнечный пляж, вы сможете вернуться к работе. Но это не избавит вас от бессонницы. Нам платят за то, чтобы мы по восемь часов в день наблюдали за худшими проявлениями человечества. Это не та работа, которую можно оставить в офисе и забыть на выходные», — говорится в записке.

И даже если страдающим от ПТСР модераторам все же выплатят компенсации, это вряд ли кардинально решит проблему. Действующим сотрудникам придется и дальше ежедневно смотреть на расчлененку, убийства и издевательства над детьми. Без какой-либо психологической помощи.

В 2020 году Центр бизнеса и прав человека при Нью-Йоркском университете предложил создателям Facebook несколько решений, которые облегчили бы жизнь модераторам и сделали систему более эффективной. Соцсети необходимо как минимум удвоить количество модераторов и взять их всех на штатную работу. Это позволит компании внимательнее следить за психическим состоянием своих сотрудников. Однако Facebook никак не отреагировал на призыв.

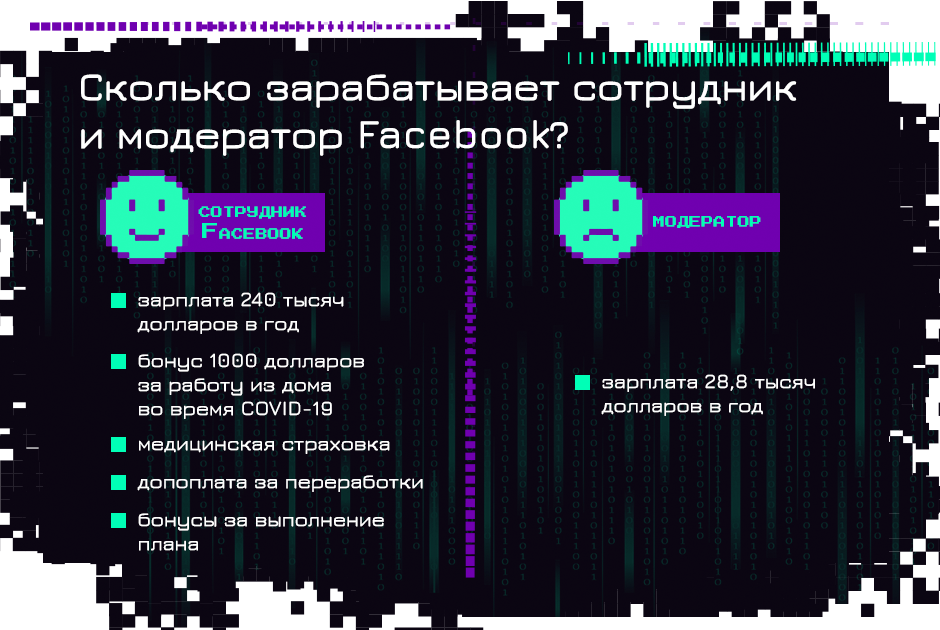

В Центре считают, что халатное отношение соцсетей к проблемам модерации частично связано с финансовыми затратами. Изменения обойдутся компании дорого — минимум в десятки миллионов долларов. Средний сотрудник Facebook зарабатывает 240 тысяч долларов в год с учетом бонусов, а модератор контента, работающий у подрядчика, получает всего 28,8 тысячи долларов в год.

Есть и вторая, более сложная для объяснения причина, почему платформа Цукерберга отказывается от усиления модерации.

«Модерация контента просто не соответствует системе ценностей Кремниевой долины. Там очень высоко ценятся продуктовые инновации, умный маркетинг, разработка… А суровый мир модерации в это просто не вписывается», — говорится в отчете Центра.

В BuzzFeed пришли к куда более грустному выводу: Facebook не просто игнорирует проблемы модерации, а намеренно оставляет на платформе мошенников, хакеров и дезинформаторов. Они распространяют вредную информацию с помощью рекламы, а Facebook получает с нее огромную прибыль.

«Facebook возьмет каждый цент, который она может заработать на чем угодно. Ей все равно, что происходит на площадке, пока она получает деньги», — так охарактеризовал происходящее в крупнейшей соцсети ее бывший сотрудник.